[英文主页] | [DJ-Cookbook] | [算子池] | [API] | [Awesome LLM Data]

Data Processing for and with Foundation Models¶

Data-Juicer 是一个一站式系统,面向大模型的文本及多模态数据处理。我们提供了一个基于 JupyterLab 的 Playground,您可以从浏览器中在线试用 Data-Juicer。 如果Data-Juicer对您的研发有帮助,请支持加星(自动订阅我们的新发布)、以及引用我们的工作 。

阿里云人工智能平台 PAI 已深度集成Data-Juicer到其数据处理产品中。PAI提供包含数据集管理、算力管理、模型工具链、模型开发、模型训练、模型部署、AI资产管理在内的功能模块,为用户提供高性能、高稳定、企业级的大模型工程化能力。数据处理的使用文档请参考:PAI-大模型数据处理。

Data-Juicer正在积极更新和维护中,我们将定期强化和新增更多的功能和数据菜谱。热烈欢迎您加入我们,一起推进大模型的数据-模型协同开发和研究应用!

[Demo Video] DataJuicer-Agent:数据处理,即刻启程!

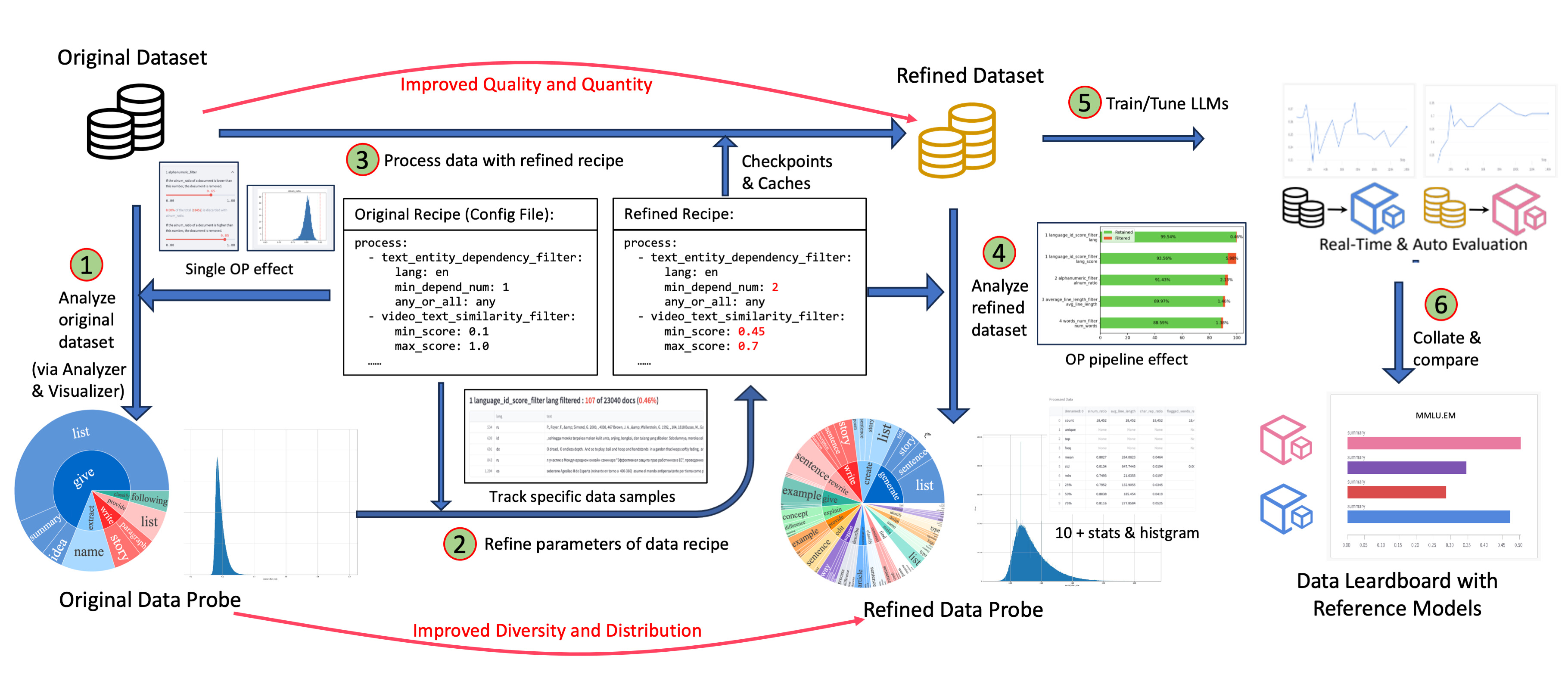

[Demo Video] DataJuicer-Sandbox: 降本增效,优化数据-模型协同开发!

新消息¶

🎉 [2025-09-19] 我们的 Data-Juicer 2.0: Cloud-Scale Adaptive Data Processing for and with Foundation Models 已被接收为 NeurIPS'25 Spotlight(处于所有投稿中的前 3.1%)!

🎉 [2025-09-19] 我们关于数据配比/选择/合成的两个工作:Diversity as a Reward: Fine-Tuning LLMs on a Mixture of Domain-Undetermined Data 和 MindGYM: What Matters in Question Synthesis for Thinking-Centric Fine-Tuning?,已被 NeurIPS'25 接收!

🛠️ [2025-06-04] 如何在“经验时代”处理反馈数据?我们提出了 Trinity-RFT: A General-Purpose and Unified Framework for Reinforcement Fine-Tuning of LLMs,该框架利用 Data-Juicer 为 RFT 场景量身定制数据处理管道。

🎉 [2025-06-04] 我们的 Data-Model Co-development 综述 已被 IEEE Transactions on Pattern Analysis and Machine Intelligence(TPAMI)接收!欢迎探索并贡献awesome-list。

🔎 [2025-06-04] 我们推出了 DetailMaster: Can Your Text-to-Image Model Handle Long Prompts? 一项合成基准测试,揭示了大模型虽擅长处理短描述,但在长提示下性能显著下降的问题。

🎉 [2025-05-06] 我们的 Data-Juicer Sandbox 已被接收为 ICML'25 Spotlight(处于所有投稿中的前 2.6%)!

💡 [2025-03-13] 我们提出MindGYM: What Matters in Question Synthesis for Thinking-Centric Fine-Tuning?。一种新的数据合成方法鼓励大模型自我合成高质量、低方差数据,实现高效SFT(如仅使用 400 个样本 即可在 MathVision 上获得 16% 的增益)。

🤝 [2025-02-28] DJ 已被集成到 Ray官方 Ecosystem 和 Example Gallery。此外,我们在 DJ2.0 中的流式 JSON 加载补丁已被 Apache Arrow 官方集成。

🎉 [2025-02-27] 我们的对比数据合成工作, ImgDiff, 已被 CVPR'25 接收!

💡 [2025-02-05] 我们提出了一种新的数据选择方法 Diversity as a Reward: Fine-Tuning LLMs on a Mixture of Domain-Undetermined Data,该方法基于理论指导,将数据多样性建模为奖励信号,在 7 个基准测试中,微调 SOTA LLMs 取得了更好的整体表现。

🎉 [2025-01-11] 我们发布了 2.0 版论文 Data-Juicer 2.0: Cloud-Scale Adaptive Data Processing for and with Foundation Models。DJ现在可以使用阿里云集群中 50 个 Ray 节点上的 6400 个 CPU 核心在 2.1 小时内处理 70B 数据样本,并使用 8 个 Ray 节点上的 1280 个 CPU 核心在 2.8 小时内对 5TB 数据进行重复数据删除。

History News:

>[2025-01-03] 我们通过 20 多个相关的新 OP 以及与 LLaMA-Factory 和 ModelScope-Swift 兼容的统一 数据集格式 更好地支持Post-Tuning场景。

[2024-12-17] 我们提出了 HumanVBench,它包含 16 个以人为中心的任务,使用合成数据,从内在情感和外在表现的角度对22个视频 MLLM 的能力进行基准测试。请参阅我们的 论文 中的更多详细信息,并尝试使用它 评估 您的模型。

[2024-11-22] 我们发布 DJ v1.0.0,其中我们重构了 Data-Juicer 的 Operator、Dataset、Sandbox 和许多其他模块以提高可用性,例如支持容错、FastAPI 和自适应资源管理。

[2024-08-25] 我们在 KDD'2024 中提供了有关多模态 LLM 数据处理的教程。

[2024-08-09] 我们提出了Img-Diff,它通过对比数据合成来增强多模态大型语言模型的性能,在MMVP benchmark中比GPT-4V高出12个点。 更多细节请参阅我们的 论文, 以及从 huggingface 和 modelscope下载这份数据集。

[2024-07-24] "天池 Better Synth 多模态大模型数据合成赛"——第四届Data-Juicer大模型数据挑战赛已经正式启动!立即访问竞赛官网,了解赛事详情。

[2024-07-17] 我们利用Data-Juicer沙盒实验室套件,通过数据与模型间的系统性研发工作流,调优数据和模型,在VBench文生视频排行榜取得了新的榜首。相关成果已经整理发表在论文中,并且模型已在ModelScope和HuggingFace平台发布。

[2024-07-12] 我们的MLLM-Data精选列表已经演化为一个模型-数据协同开发的角度系统性综述。欢迎浏览或参与贡献!

[2024-06-01] ModelScope-Sora"数据导演"创意竞速——第三届Data-Juicer大模型数据挑战赛已经正式启动!立即访问竞赛官网,了解赛事详情。

[2024-03-07] 我们现在发布了 Data-Juicer v0.2.0! 在这个新版本中,我们支持了更多的 多模态数据(包括视频) 相关特性。我们还启动了 DJ-SORA ,为SORA-like大模型构建开放的大规模高质量数据集!

[2024-02-20] 我们在积极维护一份关于LLM-Data的精选列表,欢迎访问并参与贡献!

[2024-02-05] 我们的论文被SIGMOD'24 industrial track接收!

[2024-01-10] 开启"数据混合"新视界——第二届Data-Juicer大模型数据挑战赛已经正式启动!立即访问竞赛官网,了解赛事详情。

[2024-01-05] Data-Juicer v0.1.3 版本发布了。 在这个新版本中,我们支持了更多Python版本(3.8-3.10),同时支持了多模态数据集的转换和处理(包括文本、图像和音频。更多模态也将会在之后支持)! 此外,我们的论文也更新到了第三版 。

[2023-10-13] 我们的第一届以数据为中心的 LLM 竞赛开始了! 请访问大赛官网,FT-Data Ranker(1B赛道 、7B赛道 ) ,了解更多信息。

为什么选择 Data-Juicer?¶

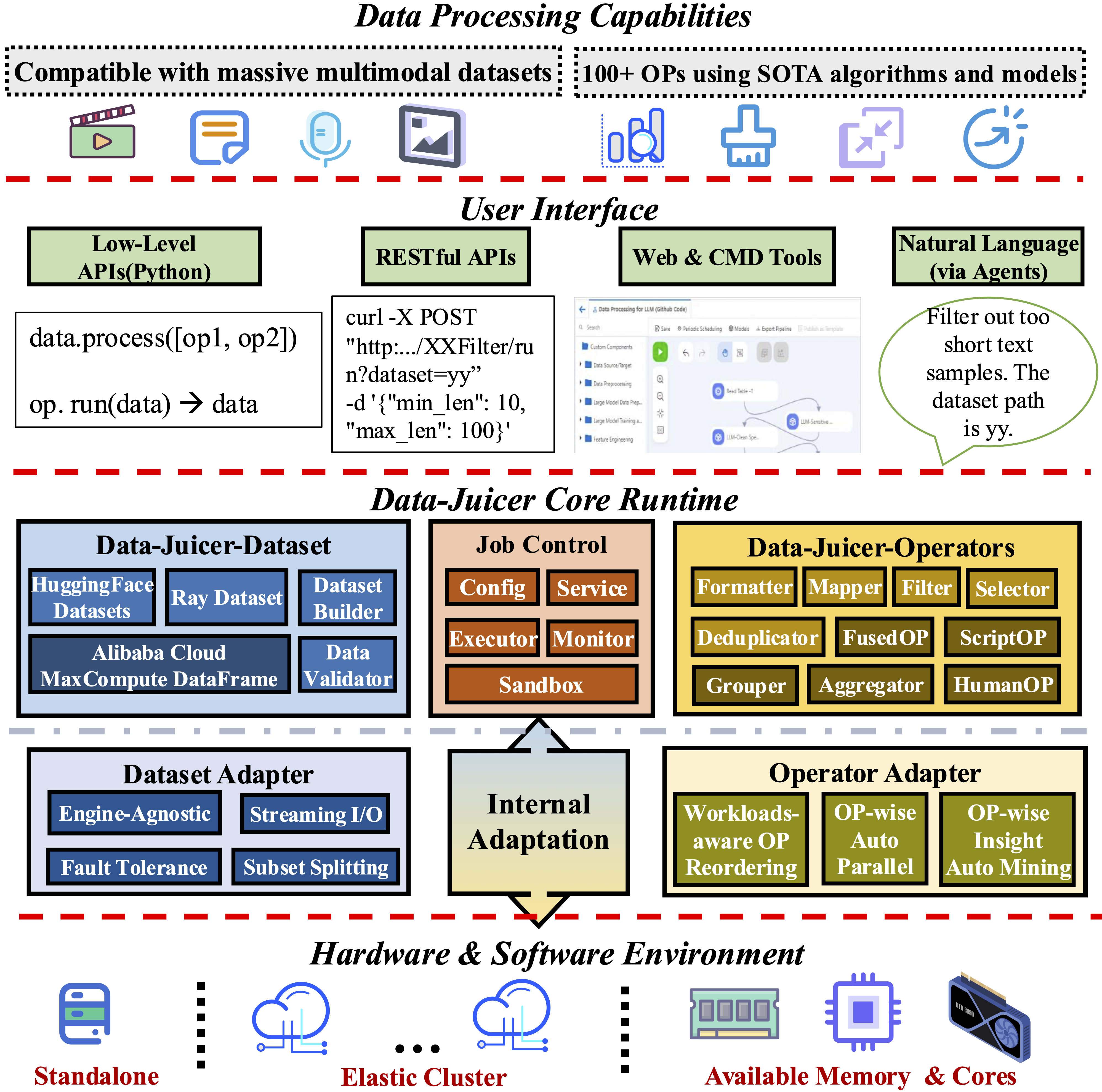

系统化和可重用: 系统化地为用户提供 100 多个核心 算子 和 50 多个可重用的数据菜谱和 专用工具套件,旨在解耦于特定的多模态 LLM 数据集和处理管道运行。支持预训练、后训练、英语、中文等场景中的数据分析、清洗和合成。

易用、可扩展: 简洁灵活,提供快速入门指南和包含丰富使用示例的DJ-Cookbook。您可以灵活实现自己的OP,自定义数据处理工作流。

Data-Juicer 现采用 AI 自动重写和优化算子的 docstring,并生成详细的算子文档,帮助更快理解每个算子的功能及用法。

如需了解该文档增强流程的具体实现,欢迎访问 dj_agents 分支下的 demos/op_doc_enhance_workflow 文件夹。

文档¶

教程

其他帮助文档

Demos

工具

第三方

开源协议¶

Data-Juicer 在 Apache License 2.0 协议下发布。

贡献与致谢¶

Data-Juicer 的发展离不开社区的参与和反馈,非常欢迎各方面的贡献:开发新的算子(无论是简单函数还是现有论文的先进算法)、分享新的数据菜谱和使用场景、提出新功能需求、提升代码效率、修复程序错误、完善项目文档、反馈使用体验等。您可参考开发者指南开启贡献;在社区中宣传本项目,或为我们的代码仓库点亮星标 ⭐,同样是对该项目非常宝贵的支持!

我们由衷感谢所有为本项目做出贡献的代码贡献者,他们是本项目的基石。我们尽力确保以下名单的完整和及时,并期待更多名字的加入(英文字母序排列)。若有疏漏,请随时联系我们。

发起方: 阿里巴巴通义实验室

联合研发优化: 阿里云PAI、Anyscale (Ray Team)、中山大学 (知识工程实验室)、NVIDIA (NeMo Team) 等

用户/提供无价反馈: AgentScope、阿里巴巴集团、蚂蚁集团、比亚迪、字节跳动、DiffSynth-Studio、EasyAnimate、Eval-Scope、京东、LLaMA-Factory、南京大学、OPPO、北京大学、RM-Gallery、中国人民大学、清华大学、Trinity-RFT、中国科学院、中国科学院大学、小红书、小米、喜马拉雅、浙江大学等

其它项目: Data-Juicer 也感谢许多先驱开源项目,例如 Apache Arrow、BLOOM、Hugging Face Datasets、RedPajama-Data、Ray、vLLM 等

我们期待您的反馈与合作。如您有合作意向或关于新子项目的提案,欢迎通过 GitHub Issues、Pull Requests、Slack 频道、钉钉群或邮件与我们联系。

参考文献¶

如果您发现Data-Juicer对您的研发有帮助,请引用以下工作,1.0paper, 2.0paper。

@inproceedings{djv1,

title={Data-Juicer: A One-Stop Data Processing System for Large Language Models},

author={Daoyuan Chen and Yilun Huang and Zhijian Ma and Hesen Chen and Xuchen Pan and Ce Ge and Dawei Gao and Yuexiang Xie and Zhaoyang Liu and Jinyang Gao and Yaliang Li and Bolin Ding and Jingren Zhou},

booktitle={International Conference on Management of Data},

year={2024}

}

@article{djv2,

title={Data-Juicer 2.0: Cloud-Scale Adaptive Data Processing for and with Foundation Models},

author={Chen, Daoyuan and Huang, Yilun and Pan, Xuchen and Jiang, Nana and Wang, Haibin and Zhang, Yilei and Ge, Ce and Chen, Yushuo and Zhang, Wenhao and Ma, Zhijian and Huang, Jun and Lin, Wei and Li, Yaliang and Ding, Bolin and Zhou, Jingren},

journal={Advances in Neural Information Processing Systems},

year={2025}

}

更多Data-Juicer团队关于数据的论文:

>(ICML'25 Spotlight) Data-Juicer Sandbox: A Feedback-Driven Suite for Multimodal Data-Model Co-development

(CVPR'25) ImgDiff: Contrastive Data Synthesis for Vision Large Language Models

(NeurIPS'25) Diversity as a Reward: Fine-Tuning LLMs on a Mixture of Domain-Undetermined Data

(NeurIPS'25) MindGYM: What Matters in Question Synthesis for Thinking-Centric Fine-Tuning?

(Benchmark Data) HumanVBench: Exploring Human-Centric Video Understanding Capabilities of MLLMs with Synthetic Benchmark Data

(Benchmark Data) DetailMaster: Can Your Text-to-Image Model Handle Long Prompts?

(Data Scaling) BiMix: A Bivariate Data Mixing Law for Language Model Pretraining

-B31B1B?logo=arxiv&logoColor=red)